Studiennotizen zu einem Bericht der Deutschen Bank, in denen mehrere häufige Fehler bei quantitativen Strategien aufgelistet werden

0

0

2283

2283

Studiennotizen zu einem Bericht der Deutschen Bank, in denen mehrere häufige Fehler bei quantitativen Strategien aufgelistet werden

- ### Die Überlebens-Bias

Die Überlebensverzerrung ist eines der häufigsten Probleme, mit denen sich Anleger konfrontiert sehen, und viele wissen, dass sie existiert, aber nur wenige werten ihre Auswirkungen ernst. Wir neigen dazu, bei der Rückmeldung nur noch bestehende Unternehmen zu verwenden, was bedeutet, dass wir die Auswirkungen von Unternehmen, die aufgrund von Insolvenzen oder Umstrukturierungen aus dem Markt genommen wurden, ausgeschlossen haben.

Bei der Anpassung an historische Daten werden regelmäßig einige Insolvenz-, Rücknahme- und schlechte Performance-Aktien ausgeschlossen. Diese ausgegrenzten Aktien sind nicht in Ihrem Strategie-Stockpool enthalten, d. h. bei der Rückmessung der Vergangenheit werden nur Informationen über die aktuellen Bestandteile verwendet, ohne die Auswirkungen von Aktien, die in der Zukunft aufgrund schlechter Performance oder Aktienpreise aus den Bestandteilen ausgeschlossen wurden.

Abbildung 1

Abbildung 1

Die Überlebensverzerrung ist eines der häufigsten Probleme, mit denen sich Anleger konfrontiert sehen, und viele wissen, dass sie existiert, aber nur wenige werten ihre Auswirkungen ernst. Wir neigen dazu, bei der Rückmeldung nur noch bestehende Unternehmen zu verwenden, was bedeutet, dass wir die Auswirkungen von Unternehmen, die aufgrund von Insolvenzen oder Umstrukturierungen aus dem Markt genommen wurden, ausgeschlossen haben.

Bei der Anpassung an historische Daten werden regelmäßig einige Insolvenz-, Rücknahme- und schlechte Performance-Aktien ausgeschlossen. Diese ausgegrenzten Aktien sind nicht in Ihrem Strategie-Stockpool enthalten, d. h. bei der Rückmessung der Vergangenheit werden nur Informationen über die aktuellen Bestandteile verwendet, ohne die Auswirkungen von Aktien, die in der Zukunft aufgrund schlechter Performance oder Aktienpreise aus den Bestandteilen ausgeschlossen wurden.

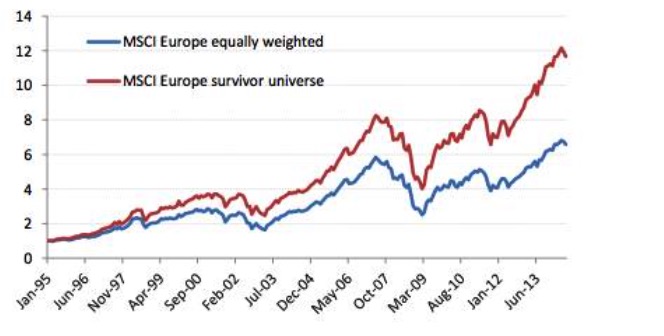

Abbildung 2

Abbildung 2

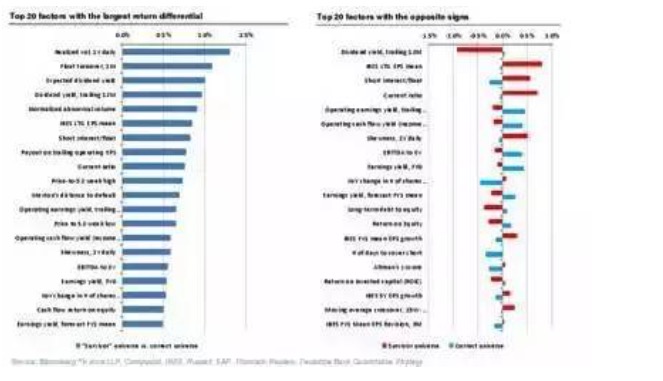

Das heißt, wenn wir die besten Firmen der letzten 30 Jahre zurückverfolgen, die ein hohes Kreditrisiko hatten, wenn man weiß, wer überleben wird, dann ist der Ertrag sehr hoch, wenn man ein hohes Kreditrisiko hat oder wenn man in Schwierigkeiten ist. Wenn man die Insolvenz, die Veräußerung und die schlechten Aktien berücksichtigt, kommt man zu dem Gegenteil.

Es gibt viele andere Faktoren, die bei der Berücksichtigung der Überlebensverzerrung das Gegenteil bewirken.

Abbildung 3

Abbildung 3

- ### 2. Blick nach vorne.

Abbildung 4

Abbildung 4

Die Überlebensverzerrung, eine der sieben Sünden, ist die Tatsache, dass wir an einem Punkt in der Vergangenheit nicht vorhersagen können, welche Unternehmen überleben werden und noch heute Bestandteile des Index sind, und die Überlebensverzerrung ist nur ein besonderes Beispiel für die Zukunftsverzerrung. Die Zukunftsverzerrung bezieht sich auf die Verwendung von Daten, die zu diesem Zeitpunkt nicht verfügbar oder noch nicht veröffentlicht waren, und ist der häufigste Fehler in der Rückmeldung.

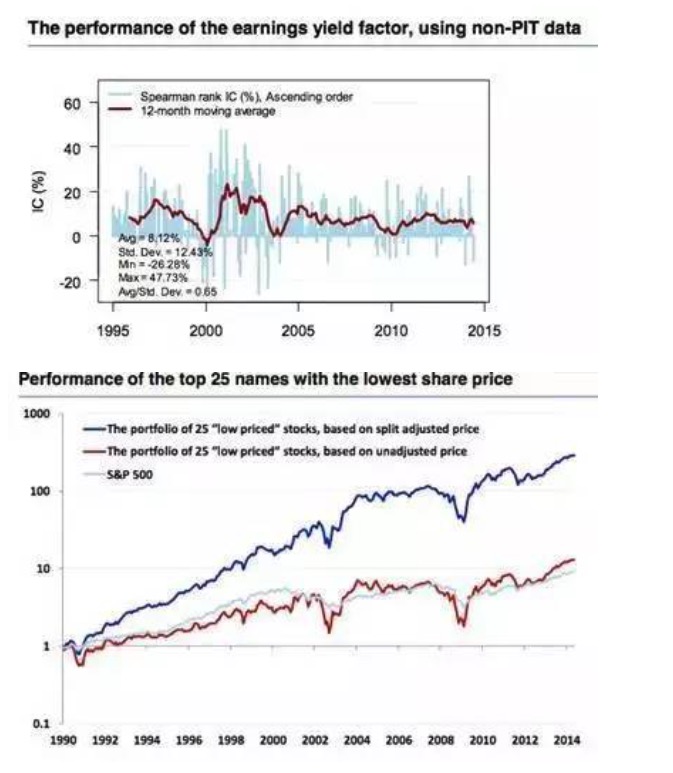

Ein sehr deutliches Beispiel für die Prognoseverzerrung zeigt sich in den Finanzdaten, während die Korrektur der Finanzdaten eher zu schwer zu entdeckenden Fehlern führt. Im Allgemeinen gibt es verschiedene Zeitpunkte für die Veröffentlichung der Finanzdaten der einzelnen Unternehmen und es gibt oft Verzögerungen.

Wenn jedoch keine Punktdaten (Point-in-time data, kurz PIT data) verfügbar sind, ist die Verzögerung der Annahme der Finanzberichte oft falsch. Die folgende Abbildung bestätigt die Unterschiede, die durch die Verwendung von PIT-Daten im Vergleich zu Nicht-PIT-Daten verursacht werden. Außerdem erhalten wir bei der Herunterladen historischer Makro-Daten häufig die endgültige Berichtigung, die jedoch nach der Veröffentlichung der BIP-Daten in vielen entwickelten Ländern zweimal angepasst wird.

Abbildung 5

Abbildung 5

- ### Die Sünde des Storytelling

Abbildung 6

Abbildung 6

Einige Leute erzählen gerne Geschichten ohne Daten, andere erzählen Geschichten mit Daten und Ergebnissen. Es gibt viele Ähnlichkeiten zwischen den beiden Situationen. Die Menschen, die gut Geschichten erzählen oder die Daten interpretieren können, haben oft bereits ein vorgefertigtes Skript, bevor sie die Daten erhalten.

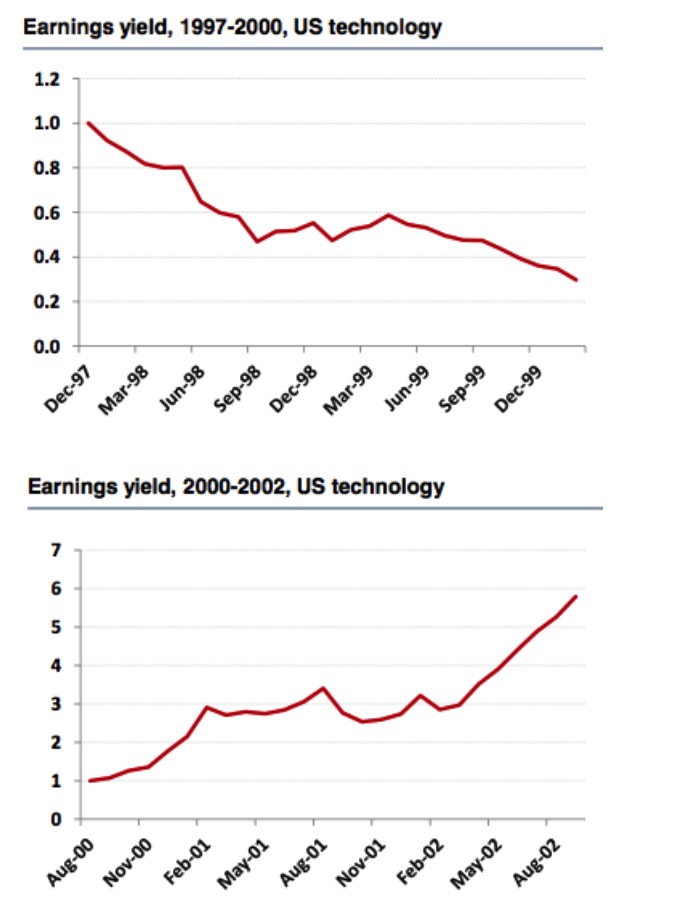

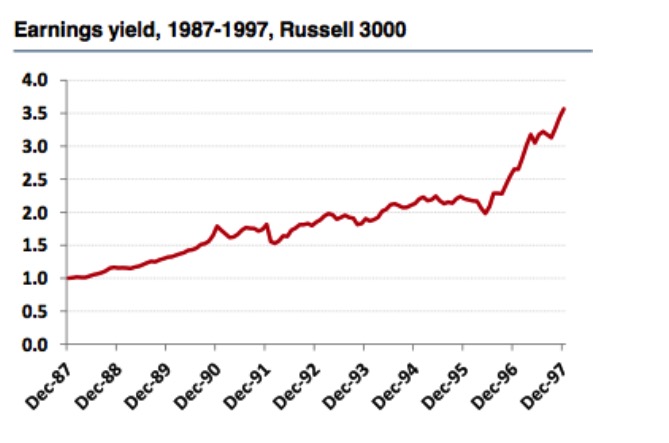

Betrachtet man die US-amerikanischen Technologie-Faktoraktien und den Russell 3000-Index für die Zeiträume 1997-2000 und 2000-2002, so kommt man zu einem völlig entgegengesetzten Ergebnis. Von den US-amerikanischen Technologie-Faktoraktien für die Zeiträume 1997-2000 ist die Marge ein guter Faktor, und die Rückmeldung ist sehr zuverlässig, aber wenn man den Zeitraum bis 2002 verlängert, dann ist der Margenindex kein guter Faktor mehr.

Abbildung 7

Abbildung 7

Aber aus der Marktergebnis des Russell 3000 Index kommen wir zu dem Gegenteil, dass der Gewinnrate-Index immer noch ein effektiver Faktor ist, und man kann sehen, dass die Länge der Auswahl und Rückmessung des Aktienpools einen großen Einfluss auf die Effektivität des Faktors hat.

Abbildung 8

Abbildung 8

Der Markt entdeckt jeden Tag neue gute Faktoren und sucht nach Motivationen. Die Strategien, die veröffentlicht werden können, zeigen eine gute Rückmeldung. Obwohl die Geschichtenerzähler die Geschichte sehr gut interpretieren, sind ihre Vorhersagen für die Zukunft fast unbrauchbar.

- ### 4. Datamining und Daten-Snooping

Abbildung 9

Abbildung 9

Daten-Mining ist ein Bereich, der derzeit sehr stark betroffen ist. Auf der Grundlage von riesigen Datenmengen und der Rechenleistung von Computern erhofft man sich oft, dass man die schwer wahrnehmbaren positiven Faktoren erkennt. Die ursprünglichen Finanzdaten sind jedoch noch nicht so groß, und die Transaktionsdaten erfüllen nicht die Voraussetzungen für eine geringe Geräuschpegel.

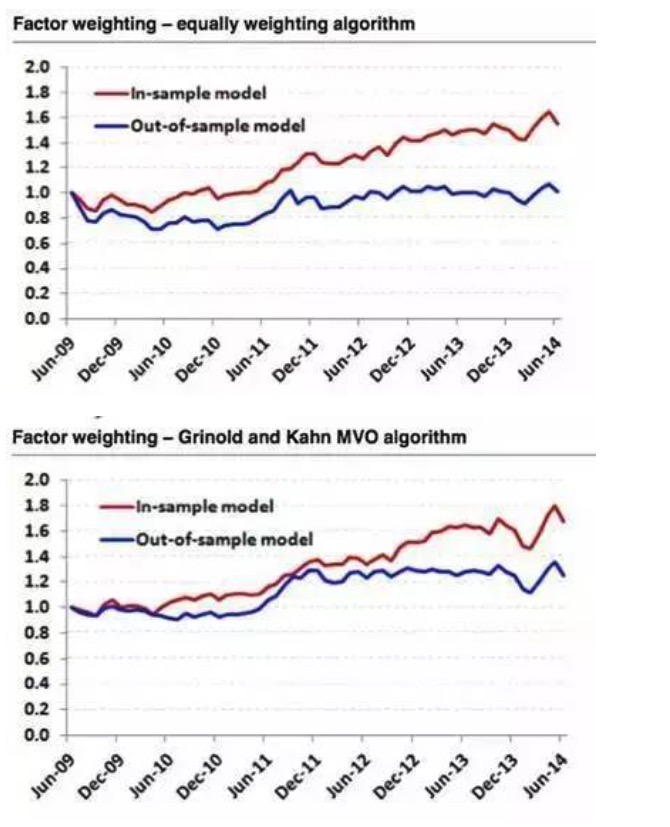

Manchmal ist die Datengewinnung nahezu unwirksam. Zum Beispiel haben wir den S&P 500 mit zwei verschiedenen Faktorgewichtungsalgorithmen modelliert und die Daten für die Jahre 2009-2014 ausgewählt. Die Ergebnisse zeigen, dass die sechs bestperformenden Faktoren aus den Daten für die Jahre 2009-2014 ausgewählt wurden. Die Ergebnisse der Rückgewinnung mit einem Gleichgewichtungsalgorithmus waren perfekt, während die Ergebnisse der Rückgewinnung mit historischen Daten eine gerade Linie waren.

Abbildung 10

Abbildung 10

Quantitative Analyse ist nur ein Werkzeug, um unsere eigene Logik oder Motivation zu überprüfen, und nicht eine logische Abkürzung. Im Allgemeinen haben wir die Motivation, Strategien zu entwickeln oder Faktoren zu suchen, aus den Bereichen der Grundlagen der Theorie der Finanzwissenschaft, der Effektivität der Märkte und der Verhaltensfinanzierung.

- ### Fünftens: Signalverfall, Umsatz und Transaktionskosten.

Abbildung 11

Abbildung 11

Signal-Deflation bezieht sich auf die Fähigkeit, zu prognostizieren, wie lange ein Aktienertrag in der Zukunft sein wird, nachdem ein Faktor erzeugt wurde. Im Allgemeinen sind hohe Wechselkurse und Signal-Deflation verbunden. Verschiedene Aktienwahlfaktoren haben oft unterschiedliche Informations-Deflationseigenschaften. Je schneller ein Signal-Deflation abläuft, desto höher ist die Wechselkurse, um Gewinne zu erzielen.

Wie kann man die optimale Anpassungsfrequenz bestimmen? Es ist wichtig zu beachten, dass die Verschärfung der Wechselkursbeschränkungen nicht bedeutet, die Anpassungsfrequenz zu verringern. Zum Beispiel hören wir oft Ähnlichkeiten wie “Wir sind langfristige Wertinvestoren, wir erwarten, dass wir die Aktien für 3-5 Jahre halten”.

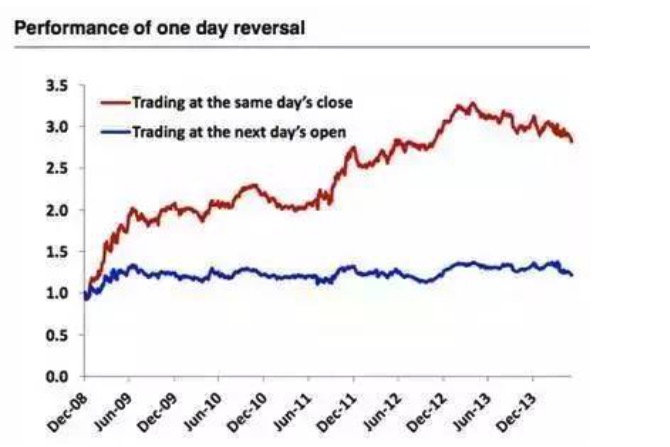

Abbildung 12

Abbildung 12

Wenn man am Ende eines Tages die 100 schlechtesten Aktien des Tages kauft, verkauft man die bisherigen Positionen und handelt täglich weiter, die Rendite ist sehr hoch. Hier ist es auch eine Fehler der Prognoseverzerrung, noch nicht am Ende der Börse wissen wir nicht, welche Aktien am schlechtesten am Tag funktionieren, d.h. die Verwendung von programmierten Geschäften ist auch nicht möglich.

- ### 6. Ausnahmewerte

Abbildung 13

Abbildung 13

Traditionelle Techniken zur Steuerung von Abweichungen umfassen hauptsächlich Winsorization und Truncation. Die Standardisierung der Daten kann als eine der Methoden zur Steuerung von Abweichungen angesehen werden. Standardisierte Techniken können einen signifikanten Einfluss auf die Modellleistung haben.

Abbildung 14

Abbildung 14

Obwohl es möglich ist, dass Ausnahmen nützliche Informationen enthalten, enthalten sie in den meisten Fällen keine nützliche Informationen. Natürlich ist dies eine Ausnahme für den Preisdynamikfaktor. Wie in der folgenden Abbildung zu sehen ist, ist die blaue Linie die kombinierte Leistung nach der Entfernung der Ausnahmen, die rote Linie ist die ursprüngliche Daten.

Abbildung 15

Abbildung 15

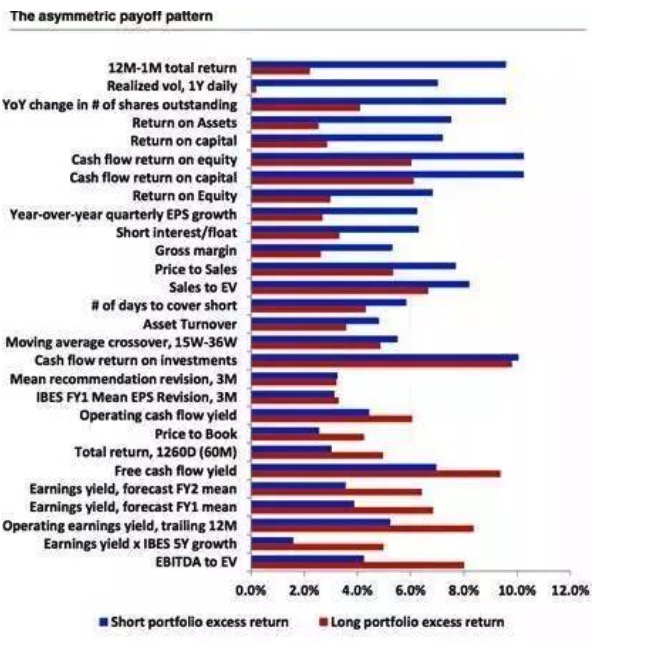

- ### Das asymmetrische Payoff-Muster und Shorting

Abbildung 16

Abbildung 16

In der Regel ist die häufigste Strategie bei der Multi-Faktor-Strategie die Multi-Höhl-Strategie, d. h. die Tatsache, dass viele gute Aktien gleichzeitig mit einem Defizit gehandelt werden. Leider sind nicht alle Faktoren gleich, und die Mehrheit der Faktoren hat eine asymmetrische Ertragscharakteristik, die mit den möglichen Kosten und der Realisierbarkeit von Defiziten verbunden ist.

Abbildung 17

Abbildung 17

Quelle: Wandern auf der Wall Street