Vorläufige Erforschung der Python Crawler Applikation auf der FMZ Plattform -- Crawling der Inhalte von Binance Ankündigung

Schriftsteller:FMZ~Lydia, Erstellt: 2022-12-16 14:32:19, Aktualisiert: 2024-12-04 21:42:15

Vorläufige Erforschung der Python Crawler-Anwendung auf der FMZ-Plattform Crawling der Inhalte von Binance Ankündigung

Vor kurzem habe ich gesehen, dass es keine relevanten Informationen über Python-Crawler in der Community und Bibliothek gibt, basierend auf dem Geist der Allround-Entwicklung von QUANT, habe ich einige Konzepte und Kenntnisse im Zusammenhang mit Crawlern einfach gelernt. Nach einigem Verständnis habe ich festgestellt, dass die

Nachfrage

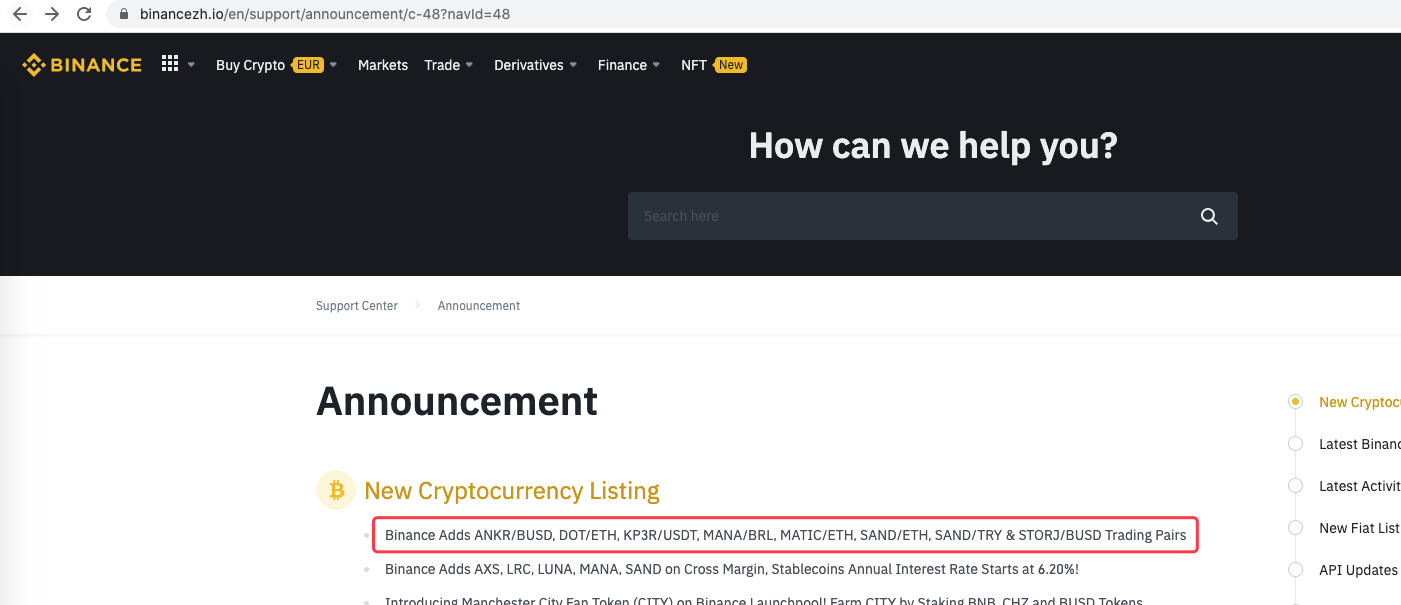

Für diejenigen, die gerne neue Aktien abonnieren, hoffen sie immer, die Informationen über die Währung an der Börse beim ersten Mal zu erhalten. Es ist offensichtlich unrealistisch für Menschen, die Börse-Website die ganze Zeit zu überwachen. Dann müssen Sie das Crawler-Skript verwenden, um die Börsenankündigungsseite zu überwachen und neue Ankündigungen zu erkennen, damit Sie beim ersten Mal benachrichtigt und erinnert werden können.

Vorläufige Erkundung

Ein sehr einfaches Programm wird verwendet, um zu starten (ein wirklich leistungsstarkes Crawler-Skript ist viel komplexer, also nehmen Sie sich zuerst Zeit). Die Programmlogik ist sehr einfach. Es ermöglicht dem Programm, ständig auf die Ankündigungsseite der Börse zuzugreifen, den erhaltenen HTML-Inhalt zu analysieren und zu erkennen, ob der spezifische Label-Inhalt aktualisiert wird.

Durchführungscode

Sie können einige nützliche Crawler-Frameworks verwenden. Da die Anforderungen jedoch sehr einfach sind, können Sie sie direkt schreiben.

Die folgenden Python-Bibliotheken müssen verwendet werden:

```Bs4```, which can be simply understood as a library used to parse HTML code on web pages.

Code:

aus bs4 importieren BeautifulSoup Einfuhranträge

UrlBinanceAnkündigung =

Definition von offen Url:

Überschriften = {

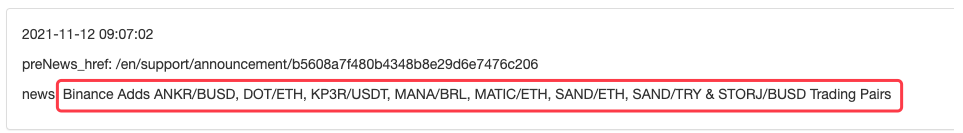

Definition der Haupt*:

PreNews_href =

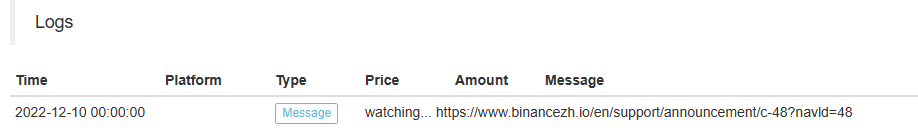

Betrieb

Sie kann beispielsweise verlängert werden, wenn eine neue Ankündigung erkannt wird.

- Quantitative Praxis der DEX-Börsen (2) -- Benutzerhandbuch für Hyperflüssigkeiten

- DEX-Börsen Quantitative Praxis ((2) -- Hyperliquid Benutzerhandbuch

- Quantitative Praxis der DEX-Börsen (1) -- dYdX v4 Benutzerhandbuch

- Einführung in Lead-Lag-Arbitrage in Kryptowährungen (3)

- DEX-Börsen Quantitative Praxis ((1)-- dYdX v4 Benutzerhandbuch

- Einführung der Lead-Lag-Suite in der Kryptowährung (3)

- Einführung in Lead-Lag-Arbitrage in Kryptowährungen (2)

- Einführung der Lead-Lag-Suite in der digitalen Währung (2)

- Diskussion über den externen Signalempfang der FMZ-Plattform: Eine Komplettlösung für den Empfang von Signalen mit integriertem Http-Service in der Strategie

- FMZ-Plattform: Erforschung von Signalempfangsstrategien für externe Netzwerke

- Einführung in Lead-Lag-Arbitrage in Kryptowährungen (1)

- Strategie für den Kauf der Gewinner der Python-Version

- FMZ-Reise - mit Übergangsstrategie

- Sie lernen, eine Python-Strategie für eine einzige Art in eine Multi-Species-Strategie umzuwandeln.

- Implementieren Sie ein quantitatives Trading-Roboter-Zeitbeginn oder Stopp-Gadget mit Python

- Oak lehrt Sie, JS zu verwenden, um mit FMZ erweiterte API zu interagieren

- Rufen Sie Dingding-Schnittstelle, um Roboter-Push-Nachricht zu erkennen

- Ausgeglichene Strategie für die Ausgabe von Aufträgen (Lehrstrategie)

- Überlegungen zur Vermögensbewegung durch eine Kontraktsicherungsstrategie

- Viele Jahre später werden Sie feststellen, dass dieser Artikel der wertvollste in Ihrer Investitionskarriere ist - finden Sie heraus, woher die Renditen und Risiken kommen

- Neuere Einführung der offiziellen Abgabestrategie der FMZ

- Implementierung des Dual Thrust-Handelsalgorithmus mit Mylanguage auf der FMZ Quant-Plattform

- Einführung FAQ zum quantitativen Handel mit digitaler Währung

- Ein weiteres TradingView-Signal-Exekutionsstrategieschema

- Verwenden Sie die erweiterte API auf der FMZ Quant Trading Platform, um den TradingView-Alarmsignalhandel zu realisieren

- Visualisierungsmodul zum Aufbau einer Handelsstrategie - Einfache Erklärung

- Visualisierungsmodul zum Aufbau einer Handelsstrategie - Fortgeschrittenes Verständnis

- Visualisierungsmodul zum Aufbau einer Handelsstrategie - Erste Bekanntschaft

- Die Abfahrt eines erfahrenen Programmierers

- Einheitliche Plattform-Balance-Strategie von Python Version

- Überzeitliche Arbitragestrategie für digitale Währungen auf Basis des Bollinger Bands