Phân tích toàn bộ các lợi thế và nhược điểm của 3 loại thuật toán học máy lớn 6

Tác giả:Những nhà phát minh định lượng - những giấc mơ nhỏ, Tạo: 2017-10-30 12:01:59, Cập nhật: 2017-11-08 13:55:03Phân tích toàn bộ các lợi thế và nhược điểm của 3 loại thuật toán học máy lớn 6

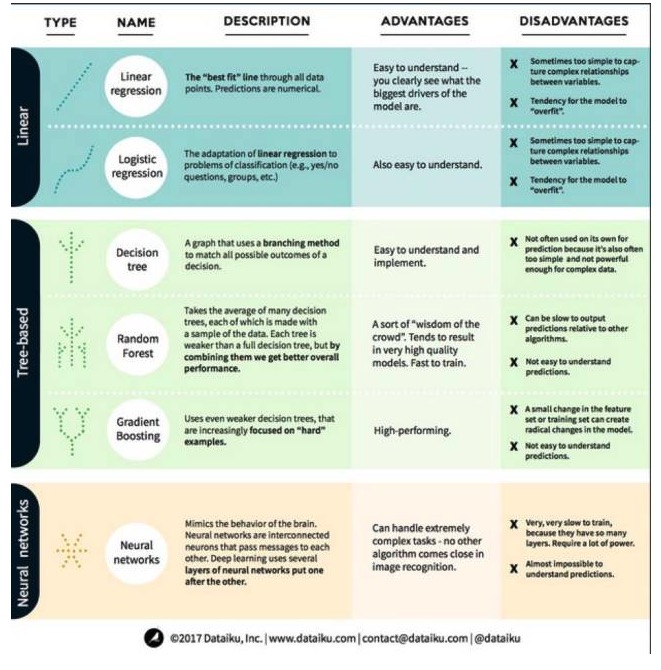

Trong học máy, mục tiêu là dự đoán hoặc nhóm. Bài viết này tập trung vào dự đoán. Dự đoán là quá trình dự đoán giá trị của các biến đầu vào từ một tập hợp các biến đầu vào. Ví dụ, lấy một tập hợp các đặc điểm liên quan đến ngôi nhà, chúng ta có thể dự đoán giá bán của nó. Các vấn đề dự đoán có thể được chia thành hai loại: 1: vấn đề hồi quy: trong đó các biến dự đoán là số (ví dụ như giá nhà); 2: các vấn đề phân loại: trong đó các biến dự đoán là câu trả lời có đúng hay không (ví dụ: dự đoán một thiết bị sẽ bị lỗi) Để hiểu được điều này, chúng ta hãy xem các thuật toán phổ biến nhất và nổi bật nhất trong máy học. Chúng ta chia chúng thành 3 loại: mô hình tuyến tính, mô hình dựa trên cây và mạng thần kinh, tập trung vào 6 thuật toán phổ biến nhất:

Một, thuật toán mô hình tuyến tính: Mô hình tuyến tính sử dụng công thức đơn giản để tìm ra các đường phù hợp nhất với các chu kỳ qua một tập dữ liệu. Phương pháp này có niên đại hơn 200 năm và được sử dụng rộng rãi trong lĩnh vực thống kê và học máy. Do sự đơn giản của nó, nó rất hữu ích cho thống kê. Các biến (vì biến) mà bạn muốn dự đoán được thể hiện bằng phương trình của các biến (vì biến) mà bạn đã biết, vì vậy dự đoán chỉ là một vấn đề nhập các biến (vì biến) và sau đó tính toán câu trả lời cho phương trình.

- ### #1. Chuyển hướng tuyến tính

Phân hồi tuyến tính, hoặc chính xác hơn là Phân hồi hai lần tối thiểu của phong cách, là hình thức tiêu chuẩn nhất của mô hình tuyến tính. Đối với các vấn đề hồi quy, phân hồi tuyến tính là mô hình tuyến tính đơn giản nhất. Nhược điểm của nó là mô hình dễ dàng quá phù hợp, tức là mô hình hoàn toàn phù hợp với dữ liệu đã được đào tạo, nhưng phải hy sinh khả năng phổ biến sang dữ liệu mới. Do đó, phân hồi tuyến tính trong máy học (và các khâu hồi quy logic mà chúng ta sẽ nói về sau) thường là phân hồi, có nghĩa là mô hình có một số hình phạt để ngăn chặn quá phù hợp.

Một nhược điểm khác của mô hình tuyến tính là vì chúng rất đơn giản, nên chúng không dễ dàng dự đoán các hành vi phức tạp hơn khi các biến nhập không độc lập.

- #### # 2. Logic Regression

Logical regression là sự thích nghi của regression tuyến tính đối với các vấn đề phân loại. Những nhược điểm của regression logic giống như regression tuyến tính. Các hàm logic rất tốt cho các vấn đề phân loại vì nó giới thiệu hiệu ứng threshold.

Thứ hai, thuật toán mô hình cây.

- ##### 1 ###, cây quyết định

Cây quyết định là một biểu đồ cho mọi kết quả có thể của quyết định bằng cách sử dụng phương pháp nhánh. Ví dụ: bạn quyết định đặt một loại salad, và quyết định đầu tiên của bạn có thể là loại lúa mì sống, sau đó là các loại lúa mì, sau đó là loại lúa mì. Chúng ta có thể biểu thị tất cả các kết quả có thể trong một cây quyết định.

Để đào tạo cây quyết định, chúng ta cần sử dụng tập dữ liệu đào tạo và tìm ra thuộc tính nào hữu ích nhất cho mục tiêu. Ví dụ, trong trường hợp sử dụng phát hiện gian lận, chúng ta có thể thấy rằng thuộc tính có ảnh hưởng lớn nhất đến việc dự đoán rủi ro gian lận là quốc gia. Sau khi phân nhánh theo thuộc tính đầu tiên, chúng ta có hai thuộc tính, điều này có thể được dự đoán chính xác nhất nếu chúng ta chỉ biết thuộc tính đầu tiên. Sau đó, chúng ta tìm ra thuộc tính thứ hai tốt nhất có thể phân nhánh cho hai thuộc tính này, sử dụng phân nhánh lại, và lặp lại cho đến khi đủ thuộc tính đáp ứng nhu cầu của mục tiêu.

- #### 2 ## # # # # # # # # # # # # # # # #

Rừng ngẫu nhiên là trung bình của nhiều cây quyết định, trong đó mỗi cây quyết định được đào tạo bằng các mẫu dữ liệu ngẫu nhiên. Mỗi cây trong rừng ngẫu nhiên yếu hơn một cây quyết định hoàn chỉnh, nhưng đặt tất cả các cây lại với nhau, chúng ta có thể đạt được hiệu suất tổng thể tốt hơn do lợi thế của sự đa dạng.

Random Forest là một thuật toán rất phổ biến trong học máy ngày nay. Random Forest rất dễ đào tạo và hoạt động khá tốt. Nhược điểm của nó là Random Forest có thể sản xuất dự đoán chậm so với các thuật toán khác, vì vậy khi cần dự đoán nhanh, bạn có thể không chọn Random Forest.

- #### 3#, nâng độ dốc

Gradient Boosting, giống như rừng ngẫu nhiên, cũng được tạo thành từ những cây quyết định yếu kém. Sự khác biệt lớn nhất giữa gradient boosting và rừng ngẫu nhiên là trong gradient boosting, cây được đào tạo một lần một lần. Mỗi cây phía sau được đào tạo chủ yếu bởi cây phía trước để nhận ra dữ liệu sai. Điều này làm cho gradient boosting tập trung nhiều hơn vào các tình huống dễ đoán hơn và tập trung nhiều hơn vào các tình huống ít khó khăn hơn.

Việc đào tạo tăng độ dốc cũng nhanh chóng và hoạt động rất tốt. Tuy nhiên, những thay đổi nhỏ trong tập dữ liệu đào tạo có thể làm thay đổi cơ bản mô hình, do đó kết quả mà nó tạo ra có thể không phải là khả thi nhất.

Các thuật toán mạng thần kinh: mạng thần kinh là một hiện tượng sinh học bao gồm các tế bào thần kinh liên kết trong não để trao đổi thông tin với nhau. Ý tưởng này hiện được áp dụng cho lĩnh vực học máy, được gọi là ANN. Học sâu là các mạng thần kinh nhiều lớp chồng lên nhau. ANN là một loạt các mô hình có khả năng nhận thức tương tự như não người bằng cách học.

Được chuyển từ Big Data Plateau

- Các nhà phát minh định lượng hỗ trợ giao dịch đồng xu của huobi và OKEX và giao dịch USDT?

- Công khai một chức năng thanh toán được tích hợp vào thư viện giao dịch tiền kỹ thuật số

- Làm thế nào để tính toán tiềm năng tài chính tối đa của chiến lược bằng cách sử dụng dữ liệu về lợi nhuận, biến động và các dữ liệu khác từ một chiến lược định lượng?

- Ma quỷ của Shannon

- Khả năng giao dịch phải phù hợp với hệ thống giao dịch

- Bạn có bất kỳ lời khuyên nào về việc đặt máy chủ không?

- Bitfinex đã chạy sai, hãy giúp phân tích, cảm ơn!

- Xin hỏi dữ liệu được truy cập khi gọi API dựa trên thời điểm nào?

- Một người đàn ông người Việt Nam có thể tìm ra mã số của đồng tiền này.

- Tại sao chỉ có bốn cặp giao dịch trong bitfinex là BCH_USD, BTC_USD, ETH_USD và LTC_USD?

- Bùng nổ 5.000 đồng mỗi đồng: làm nhiều BTC, làm trái đồng 1229 hợp đồng, một tháng, 5000 đồng mỗi đồng!

- Cơ chế quan sát cuối cùng

- Đưa ra lỗi: nút tương tác không có giá trị tham số mặc định khi tạo chính sách đã gây thất bại lưu

- Xin hỏi, hệ thống kiểm tra lại không thể chọn các loại tiền khác?

- Vui lòng dịch trang kế hoạch mua

- Bitfinex có 3 thị trường, làm thế nào để cho robot lựa chọn?

- Các lựa chọn từ góc nhìn động

- Bitfinex đánh giá lại và xác minh đồng tiền không phù hợp

- Những người tham gia vào cuộc họp này nói rằng, "Chúng ta không thể làm điều đó".

- Bithumb nhận thông tin tài khoản sai