Notes d'étude du rapport de la Deutsche Bank, énumérant plusieurs erreurs courantes dans les stratégies quantitatives

0

0

2284

2284

Notes d’étude du rapport de la Deutsche Bank, énumérant plusieurs erreurs courantes dans les stratégies quantitatives

- ### Le biais de survie

Le survivant bias est l’un des problèmes les plus courants auxquels les investisseurs sont confrontés, et beaucoup de gens savent que le survivant bias existe, mais peu d’entre eux attachent de l’importance à ses effets. Nous avons tendance à utiliser uniquement les sociétés qui existent encore dans le récapitulatif, ce qui signifie que nous avons éliminé les effets des sociétés qui ont été retirées du marché en raison de faillite, de restructuration.

Lorsque vous ajustez les données historiques, certaines actions en faillite, en liquidation ou en mauvaise performance sont périodiquement supprimées. Les actions supprimées ne figurent pas dans le pool de votre stratégie, c’est-à-dire que vous ne retracerez que les actions actuelles du composant, sans tenir compte de l’impact de celles qui seront supprimées du composant à l’avenir en raison d’une mauvaise performance ou d’une mauvaise performance du prix de l’action.

Figure 1

Figure 1

Le survivant bias est l’un des problèmes les plus courants auxquels les investisseurs sont confrontés, et beaucoup de gens savent que le survivant bias existe, mais peu d’entre eux attachent de l’importance à ses effets. Nous avons tendance à utiliser uniquement les sociétés qui existent encore dans le récapitulatif, ce qui signifie que nous avons éliminé les effets des sociétés qui ont été retirées du marché en raison de faillite, de restructuration.

Lorsque vous ajustez les données historiques, certaines actions en faillite, en liquidation ou en mauvaise performance sont périodiquement supprimées. Les actions supprimées ne figurent pas dans le pool de votre stratégie, c’est-à-dire que vous ne retracerez que les actions actuelles du composant, sans tenir compte de l’impact de celles qui seront supprimées du composant à l’avenir en raison d’une mauvaise performance ou d’une mauvaise performance du prix de l’action.

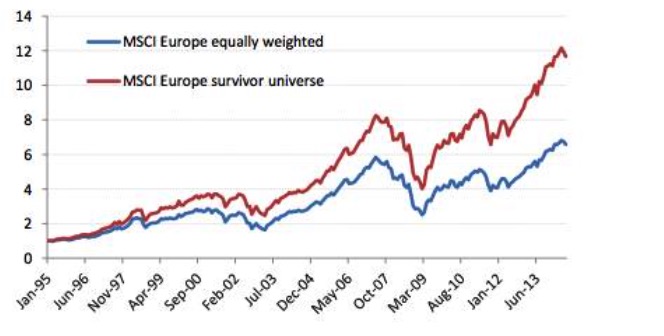

Voir le graphique 2.

Voir le graphique 2.

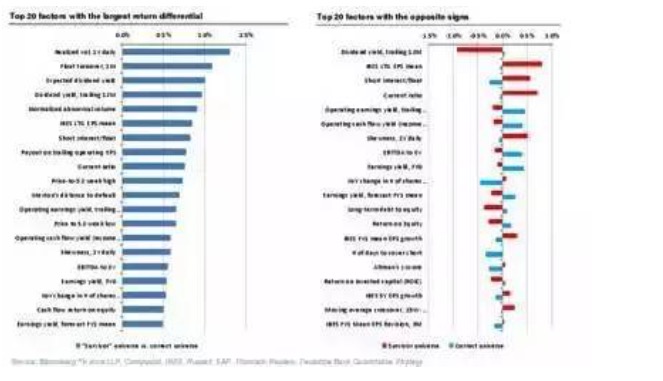

C’est-à-dire que lorsque nous utilisons les sociétés les plus performantes au cours des 30 dernières années, même si certaines sociétés étaient à risque de crédit élevé à l’époque, quand vous savez qui survivra, alors acheter quand le risque de crédit est élevé ou quand vous êtes en difficulté, les rendements sont très élevés. Si l’on prend en compte les actions qui ont fait faillite, qui ont été retirées du marché et qui ont mal performé, on arrive à la conclusion inverse: investir dans des sociétés à risque de crédit élevé a des rendements bien inférieurs à ceux des sociétés à risque de crédit stable sur le long terme.

Il y a beaucoup d’autres facteurs qui donnent les résultats opposés quand on considère le biais des survivants.

Voir aussi la figure 3.

Voir aussi la figure 3.

- ### Deuxième, le biais de l’avenir

Voir aussi la figure 4.

Voir aussi la figure 4.

Le biais de survivant, l’un des sept péchés de l’indice, est que nous ne pouvons pas prédire quelles entreprises survivront et seront toujours des actions de l’indice aujourd’hui à un moment donné dans le passé, et le biais de survivant n’est qu’un exemple particulier de biais de prospective. Le biais de prospective est l’erreur la plus courante dans la rétrospective, qui consiste à utiliser des données de rétrospective qui n’étaient pas disponibles ou qui n’étaient pas encore publiées.

L’exemple le plus évident d’un biais de prévision se trouve dans les données financières, et la correction des données financières est plus susceptible d’entraîner des erreurs difficiles à détecter. En général, les données financières de chaque entreprise sont publiées à des moments différents et sont souvent retardées.

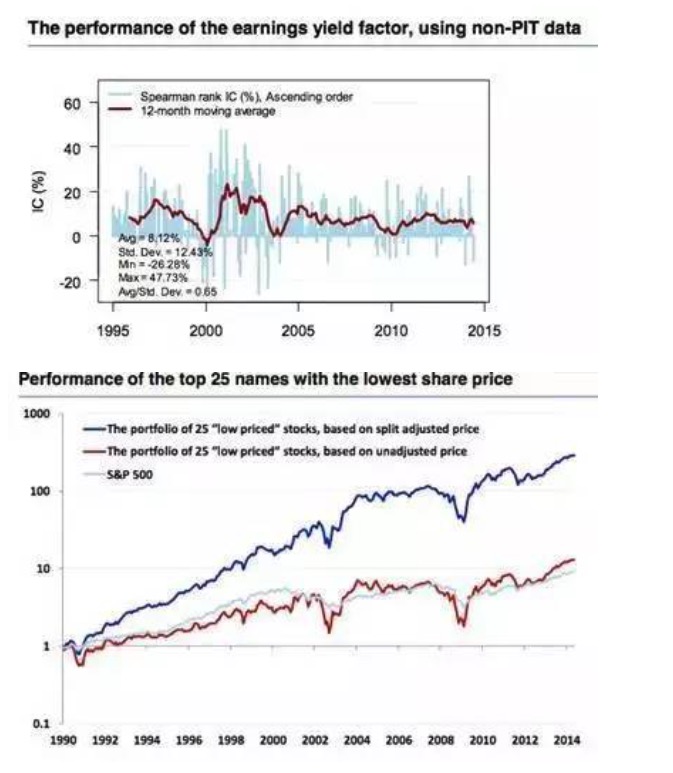

Cependant, lorsque les données ponctuelles (données PIT) ne sont pas disponibles, l’hypothèse de retard des rapports financiers est souvent erronée. La figure ci-dessous confirme les différences entre les données PIT et les données non-PIT. En outre, nous obtenons souvent des valeurs finales modifiées lors du téléchargement de données macro historiques.

Voir le graphique 5.

Voir le graphique 5.

- ### Le péché de la narration

Voir aussi la figure 6.

Voir aussi la figure 6.

Certaines personnes aiment raconter des histoires sans aucune donnée, les personnes qui font de la quantification aiment raconter des histoires avec des données et des résultats. Il y a beaucoup de similitudes entre les deux situations, les personnes qui sont bonnes à raconter des histoires ou les personnes qui sont bonnes à interpréter les résultats des données ont souvent un script établi à l’intérieur avant d’obtenir des données, il suffit de trouver le support des données.

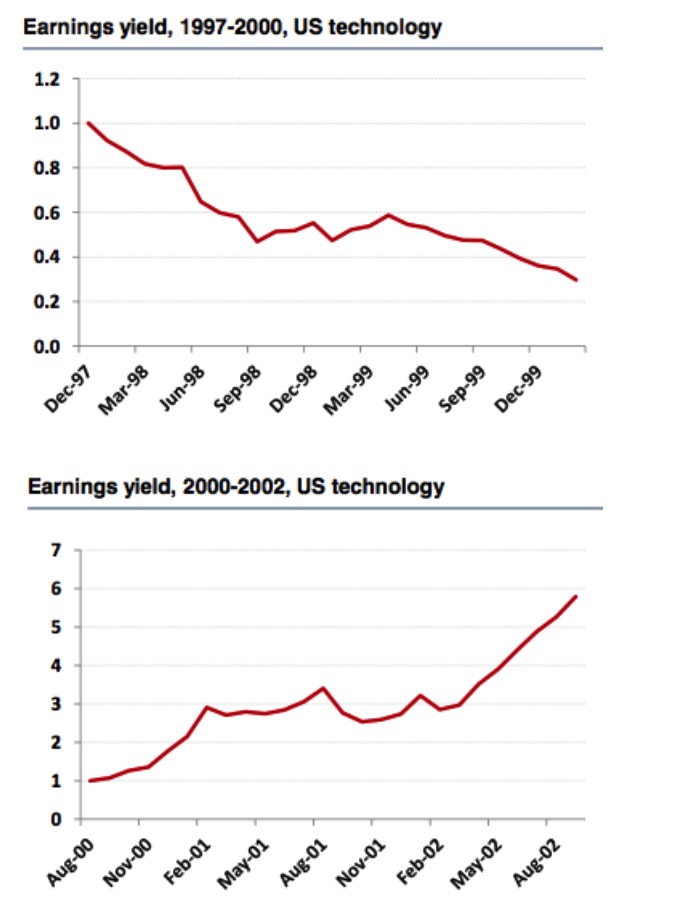

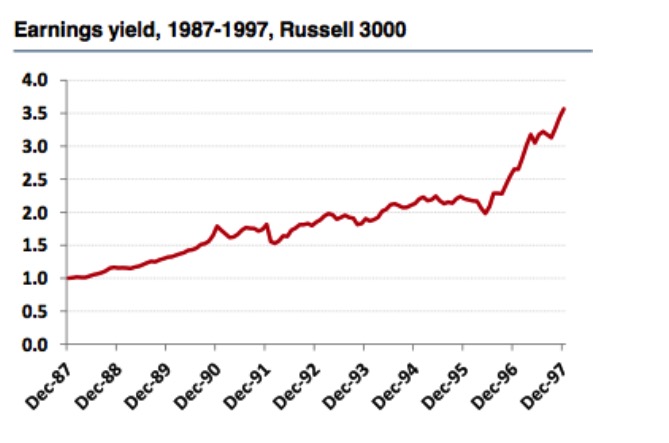

Si l’on se penche sur la composante américaine de la technologie et sur l’indice Russell 3000 pour les périodes 1997-2000 et 2000-2002, on arrive à une conclusion inverse. Le taux de marge est un bon facteur pour la composante américaine de la technologie pour la période 1997-2000 et les résultats de la rétroaction sont très fiables, mais si l’on prolonge la période jusqu’en 2002, on trouve que l’indice du taux de marge n’est plus un bon facteur.

Voir le graphique 7.

Voir le graphique 7.

Mais en regardant la performance du marché sur l’indice Russell 3000, on arrive à la conclusion inverse, que l’indice de marge est toujours un facteur efficace, et on voit que la longueur du temps de sélection et de retestation des pools d’actions a une influence considérable sur la validité de ce facteur. Donc le narrateur ne peut pas tirer la bonne conclusion.

Voir aussi la figure 8.

Voir aussi la figure 8.

Les marchés découvrent chaque jour de nouveaux facteurs positifs et la recherche de motivation permanente. Les stratégies qui peuvent être publiées sont de bonnes performances. Bien que l’interprétation de l’histoire par le narrateur soit très attrayante, ses prédictions sur l’avenir sont presque inutiles.

- ### Quatrièmement, l’exploration et l’espionnage de données

Voir aussi la figure 9.

Voir aussi la figure 9.

L’exploration de données est un domaine d’intérêt, basé sur des volumes de données et le support de la puissance de calcul de l’ordinateur. On espère souvent obtenir des facteurs positifs et négatifs qui sont difficiles à détecter.

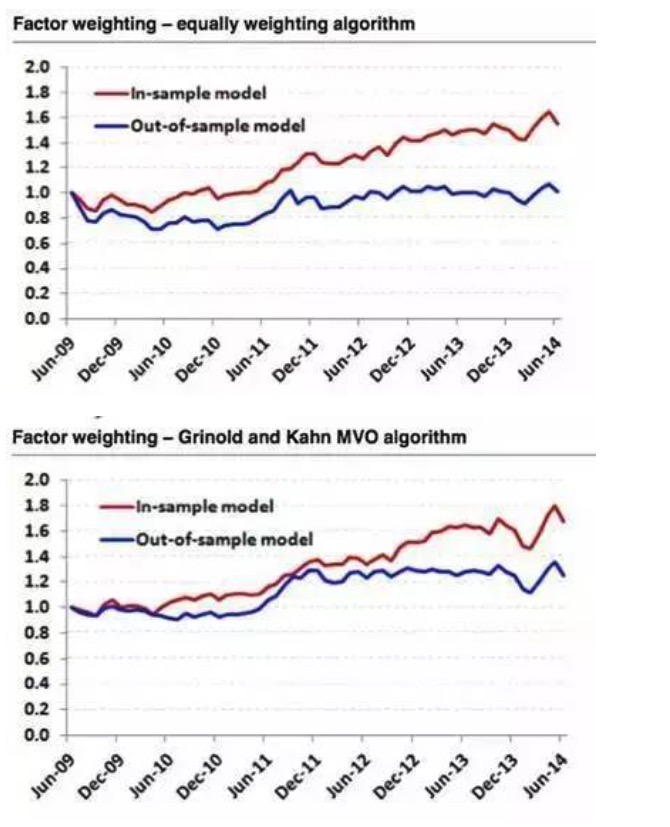

Parfois, l’extraction de données est presque inefficace. Par exemple, nous avons modélisé l’indice S&P 500 avec deux algorithmes de pondération de facteurs différents et sélectionné les données de 2009-2014 pour la rétroévaluation. Les résultats ont montré que les six facteurs les plus performants ont été sélectionnés à partir des données de 2009-2014. Les résultats de la rétroévaluation avec un algorithme de pondération équivalente étaient parfaits, alors que les résultats de la rétroévaluation avec des données historiques étaient en ligne droite.

Voir le graphique 10.

Voir le graphique 10.

Par conséquent, nous devrions tous avoir une logique et une motivation claires lorsque nous construisons une stratégie ou que nous recherchons les bons facteurs. L’analyse quantitative n’est qu’un outil pour vérifier notre propre logique ou motivation, pas une raccourci logique.

- ### Cinquièmement, le déclin du signal, le taux de change et le coût de transaction.

Voir le graphique 11.

Voir le graphique 11.

L’affaiblissement du signal est la capacité d’un facteur à prédire le rendement d’une action sur une longue période après sa création. En général, un taux de change élevé est lié à l’affaiblissement du signal. Différents facteurs de sélection d’actions ont souvent des caractéristiques d’affaiblissement de l’information différentes.

Comment déterminer la fréquence optimale d’ajustement? Il est important de noter que le resserrement des contraintes de taux de change ne signifie pas une diminution de la fréquence d’ajustement. Par exemple, nous entendons souvent des phrases similaires à celles-ci: nous sommes des investisseurs de valeur à long terme et nous prévoyons de détenir des actions pendant 3 à 5 ans. Nous pouvons donc nous ajuster une fois par an.

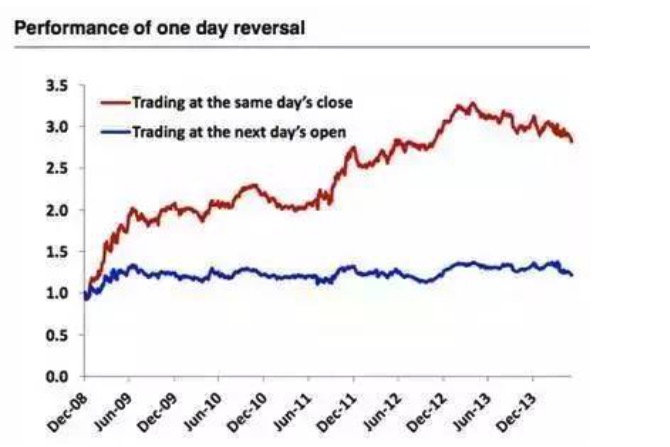

Voir aussi la figure 12.

Voir aussi la figure 12.

Lorsque nous achetons les 100 actions les moins performantes de la journée à la clôture de la journée, nous vendons les positions passées, nous continuons à négocier quotidiennement et nous obtenons un rendement très élevé. L’erreur ici est aussi un biais de prévision, nous ne savons pas encore quelles actions ont le pire rendement ce jour-là, c’est-à-dire utiliser des transactions programmées, cette stratégie est également impossible.

- ### Les valeurs exceptionnelles

Voir aussi la figure 13.

Voir aussi la figure 13.

Les techniques traditionnelles de contrôle des anomalies comprennent principalement les deux types de winsorization et de truncation. La normalisation des données peut également être considérée comme l’une des méthodes de contrôle des anomalies. La normalisation des données peut avoir un impact significatif sur la performance du modèle.

Voir aussi la figure 14.

Voir aussi la figure 14.

Bien que les anomalies puissent contenir des informations utiles, elles ne le sont pas dans la plupart des cas. Bien sûr, il y a des exceptions pour le facteur de dynamique des prix. Comme le montre le graphique ci-dessous, la ligne bleue est la performance combinée après la suppression des anomalies et la ligne rouge est les données initiales.

Voir aussi la figure 15.

Voir aussi la figure 15.

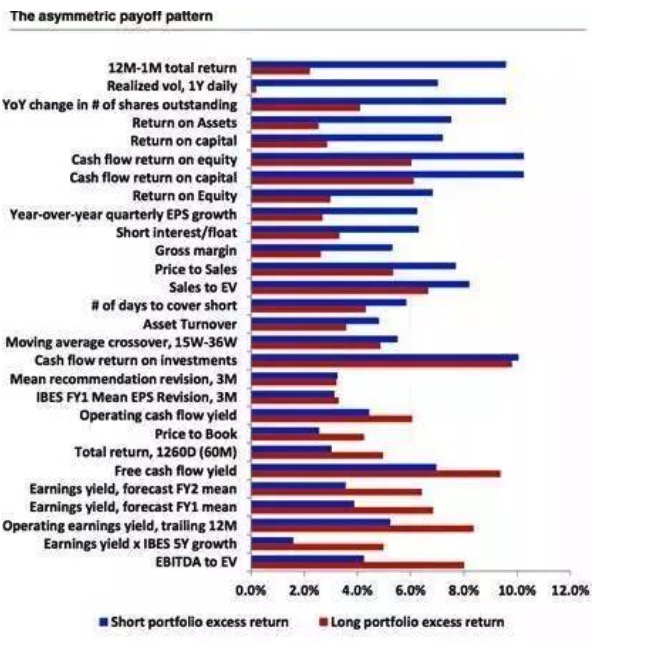

- ### Le modèle de récompense asymétrique et le court-circuit

Voir aussi la figure 16.

Voir aussi la figure 16.

En général, la stratégie la plus couramment utilisée pour faire une stratégie multifacteur est la stratégie de l’espace, c’est-à-dire faire beaucoup de bonnes actions en même temps que des actions avec un déficit de carence. Malheureusement, tous les facteurs ne sont pas égaux. Les caractéristiques de gain d’espace de la plupart des facteurs sont asymétriques, ajoutées aux coûts potentiels et à la faisabilité réelle de la carence, ce qui pose un problème considérable aux investissements quantifiés.

Voir le graphique 17.

Voir le graphique 17.

Source: Une promenade à Wall Street