Eksplorasi awal aplikasi Python Crawler di Platform FMZ -- Merayapi Konten Pengumuman Binance

Penulis:FMZ~Lydia, Dibuat: 2022-12-16 14:32:19, Diperbarui: 2024-12-04 21:42:15

Eksplorasi awal aplikasi Python Crawler di Platform FMZ Merayapi Konten Pengumuman Binance

Baru-baru ini, saya melihat bahwa tidak ada informasi yang relevan tentang crawler Python di komunitas dan perpustakaan, berdasarkan semangat pengembangan all-round QUANT, saya belajar beberapa konsep dan pengetahuan yang berkaitan dengan crawler dengan mudah. Setelah beberapa pemahaman, saya menemukan bahwa

Permintaan

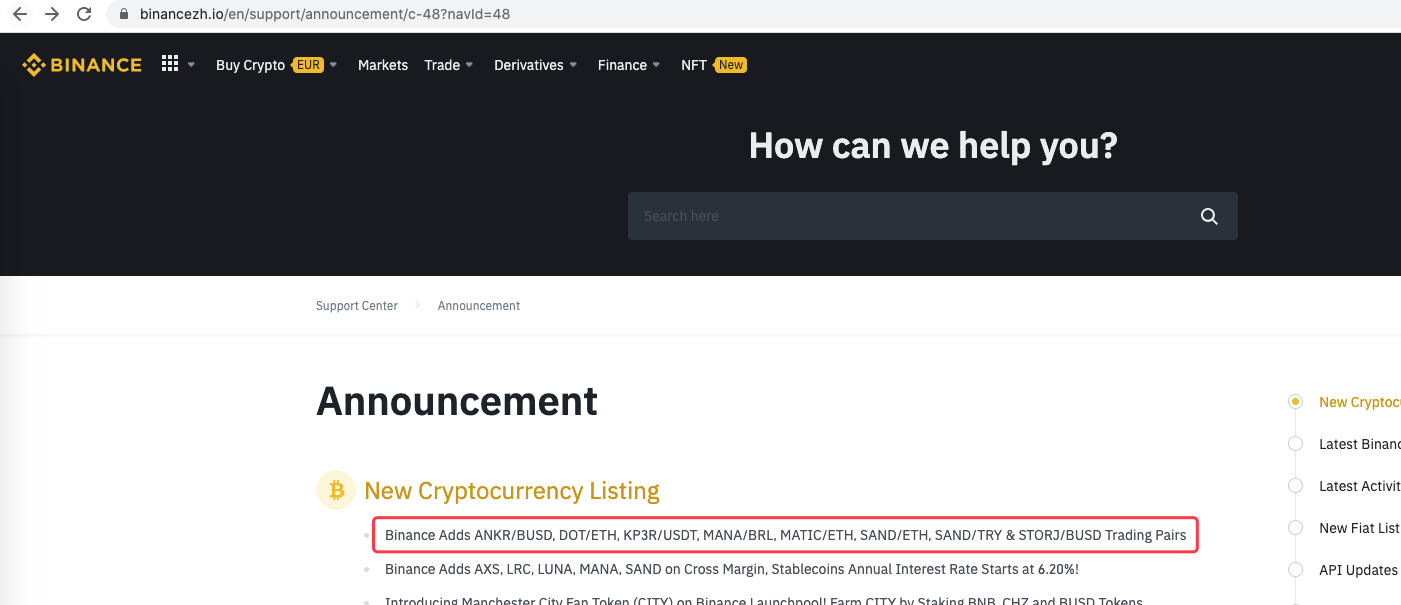

Bagi mereka yang suka berlangganan saham baru, mereka selalu berharap untuk mendapatkan informasi mata uang di bursa pada saat pertama kali. Jelas tidak realistis bagi orang untuk memantau situs web bursa sepanjang waktu. Kemudian Anda perlu menggunakan skrip perayap untuk memantau halaman pengumuman bursa dan mendeteksi pengumuman baru sehingga Anda dapat diberitahu dan diingatkan pada saat pertama kali.

Eksplorasi Awal

Sebuah program yang sangat sederhana digunakan untuk memulai (script crawler yang sangat kuat jauh lebih kompleks, jadi luangkan waktu Anda terlebih dahulu). Logika program sangat sederhana. Hal ini memungkinkan program untuk mengakses halaman pengumuman pertukaran secara konstan, menganalisis konten HTML yang diperoleh, dan mendeteksi apakah konten label tertentu diperbarui.

Kode pelaksanaan

Anda dapat menggunakan beberapa kerangka crawler yang berguna. Namun, mengingat persyaratan sangat sederhana, Anda dapat menulisnya secara langsung.

Perpustakaan python berikut harus digunakan:Requests, yang dapat dipahami sebagai perpustakaan yang digunakan untuk mengakses halaman web.Bs4, yang dapat dipahami sebagai perpustakaan yang digunakan untuk menganalisis kode HTML di halaman web.

Kode:

from bs4 import BeautifulSoup

import requests

urlBinanceAnnouncement = "https://www.binancezh.io/en/support/announcement/c-48?navId=48" # Binance announcement page address

def openUrl(url):

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.108 Safari/537.36'}

r = requests.get(url, headers=headers) # Use the requests library to access the url, i.e. the address of the Binance announcement page

if r.status_code == 200:

r.encoding = 'utf-8'

# Log("success! {}".format(url))

return r.text # Return page content text if access is successful

else:

Log("failed {}".format(url))

def main():

preNews_href = ""

lastNews = ""

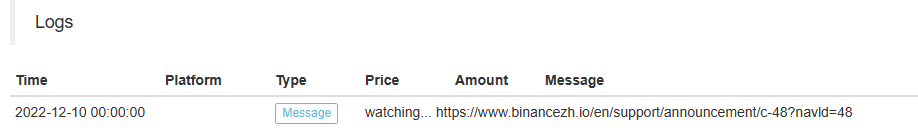

Log("watching...", urlBinanceAnnouncement, "#FF0000")

while True:

ret = openUrl(urlBinanceAnnouncement)

if ret:

soup = BeautifulSoup(ret, 'html.parser') # Parse web text into objects

lastNews_href = soup.find('a', class_='css-1ej4hfo')["href"] # Find a specific tag, get href

lastNews = soup.find('a', class_='css-1ej4hfo').get_text() # Get the content in this tag

if preNews_href == "":

preNews_href = lastNews_href

if preNews_href != lastNews_href: # A new announcement is generated when a label change is detected

Log("New Cryptocurrency Listing update!") # Print the prompt message

preNews_href = lastNews_href

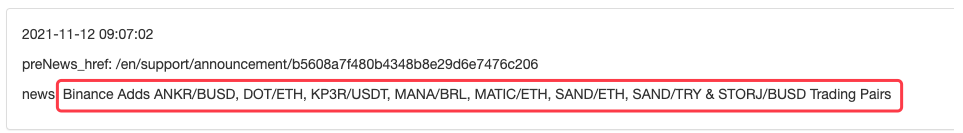

LogStatus(_D(), "\n", "preNews_href:", preNews_href, "\n", "news:", lastNews)

Sleep(1000 * 10)

Operasi

Ini dapat diperpanjang, misalnya, ketika pengumuman baru terdeteksi Menganalisis mata uang baru dalam pengumuman, dan menempatkan pesanan secara otomatis untuk berlangganan saham baru.

- Pengantar ke Lead-Lag Arbitrage dalam Cryptocurrency (2)

- Penjelasan tentang suite Lead-Lag dalam mata uang digital (2)

- Pembahasan Penerimaan Sinyal Eksternal Platform FMZ: Solusi Lengkap untuk Penerimaan Sinyal dengan Layanan Http Terbina dalam Strategi

- FMZ platform eksplorasi penerimaan sinyal eksternal: strategi built-in https layanan solusi lengkap untuk penerimaan sinyal

- Pengantar ke Lead-Lag Arbitrage dalam Cryptocurrency (1)

- Penjelasan tentang suite Lead-Lag dalam mata uang digital (1)

- Diskusi tentang Penerimaan Sinyal Eksternal dari Platform FMZ: API Terluas VS Strategi Layanan HTTP Terintegrasi

- FMZ Platform Eksternal Signal Reception: Extension API vs Strategi Layanan HTTP Terbentuk

- Diskusi tentang Metode Pengujian Strategi Berdasarkan Generator Random Ticker

- Metode pengujian strategi berdasarkan generator pasar acak

- Fitur Baru FMZ Quant: Gunakan Fungsi _Serve untuk Membuat Layanan HTTP dengan Mudah

- Strategi untuk membeli pemenang versi Python

- Perjalanan FMZ -- dengan Strategi Transisi

- Mengajarkan Anda untuk mengubah strategi Python satu spesies menjadi strategi multi spesies

- Mengimplementasikan robot perdagangan kuantitatif dimulai atau berhenti waktu gadget dengan menggunakan Python

- Oak mengajarkan Anda untuk menggunakan JS untuk antarmuka dengan FMZ diperluas API

- Panggilan Dingding antarmuka untuk menyadari robot push pesan

- Strategi Pending Order yang Seimbang (Strategi Pengajaran)

- Pikiran tentang pergerakan aset melalui strategi lindung nilai kontrak

- Bertahun-tahun kemudian, Anda akan menemukan artikel ini adalah yang paling berharga dalam karir investasi Anda - mencari tahu di mana pengembalian dan risiko berasal dari

- Perkenalan baru-baru ini dari strategi pengisian biaya resmi FMZ

- Implementasi algoritma perdagangan Dual Thrust dengan menggunakan Mylanguage pada platform FMZ Quant

- Pendahuluan FAQ untuk Perdagangan Kuantitatif Mata Uang Digital

- Sistem Strategi Eksekusi Sinyal TradingView lainnya

- Menggunakan API diperluas pada FMZ Quant Trading Platform untuk mewujudkan TradingView trading sinyal peringatan

- Modul Visualisasi untuk Membangun Strategi Trading - Penjelasan Sederhana

- Modul Visualisasi untuk Membangun Strategi Perdagangan - Pengertian Lanjutan

- Modul Visualisasi untuk Membangun Strategi Perdagangan - Kenalan Pertama

- Perjalanan dari Programmer yang berpengalaman

- Strategi Keseimbangan Platform Tunggal dari Versi Python

- Strategi Arbitrage lintas periode mata uang digital berdasarkan Bollinger Band