3つの図で機械学習を理解する: 基本概念,5つのジャンルと9つの一般的なアルゴリズム

作者: リン・ハーン発明者 量化 - 微かな夢作成日: 2017-05-02 14:49:49, 更新日:3つの図で機械学習を理解する: 基本概念,5つのジャンルと9つの一般的なアルゴリズム

- ###########################################################################################################################################################

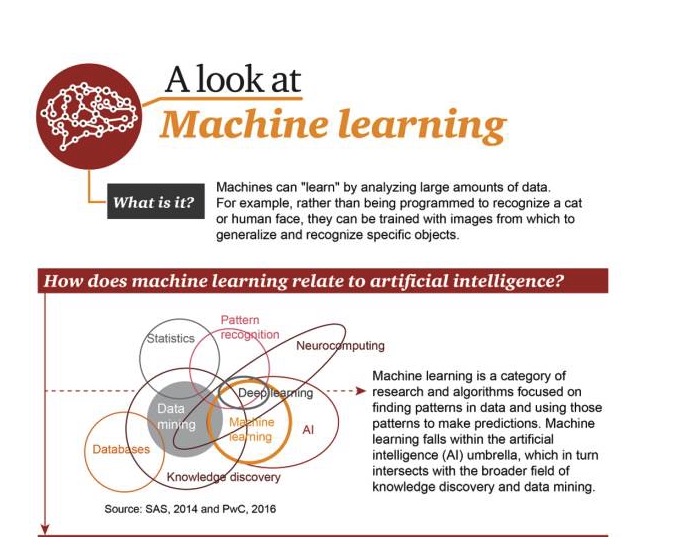

機械学習とは何か?

機械は大量のデータを分析して学習する.例えば,プログラムによって猫や人の顔を認識する必要がないので,特定の目標を集約して認識するために画像を使用して訓練することができます.

機械学習とAIの関係

機械学習は,データの中のパターンを探し,そのパターンを使って予測する研究とアルゴリズムの分野である.機械学習は,AIの領域の一部であり,知識発見とデータマイニングと交互している.

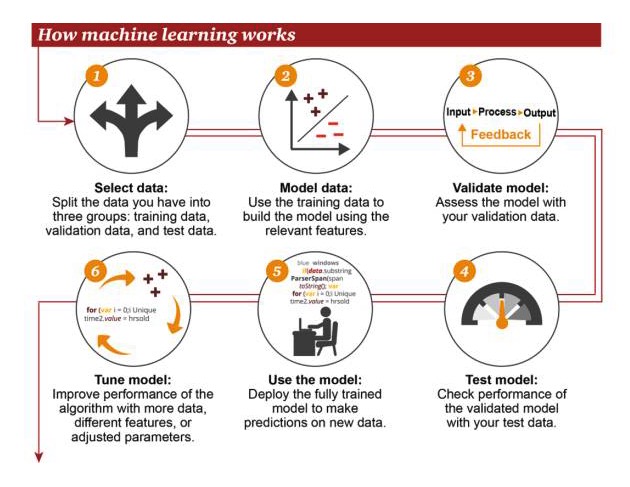

機械学習の仕組み

1 選択データ: データを3つのグループに分けます. 訓練データ,検証データ,テストデータ. 2 モデルのデータ: 関連する特徴を使用したモデルを構築するためにトレーニングデータを使用する 3 検証モデル: 検証データを使ってモデルにアクセスします 4 テストモデル: 検証されたモデルのパフォーマンスをテストする 5 モデルを使う: 完全に訓練されたモデルを使って新しいデータで予測する 6 調節モデル: アルゴリズムのパフォーマンスを向上させるために,より多くのデータ,異なる特性,または調整されたパラメータを使用する

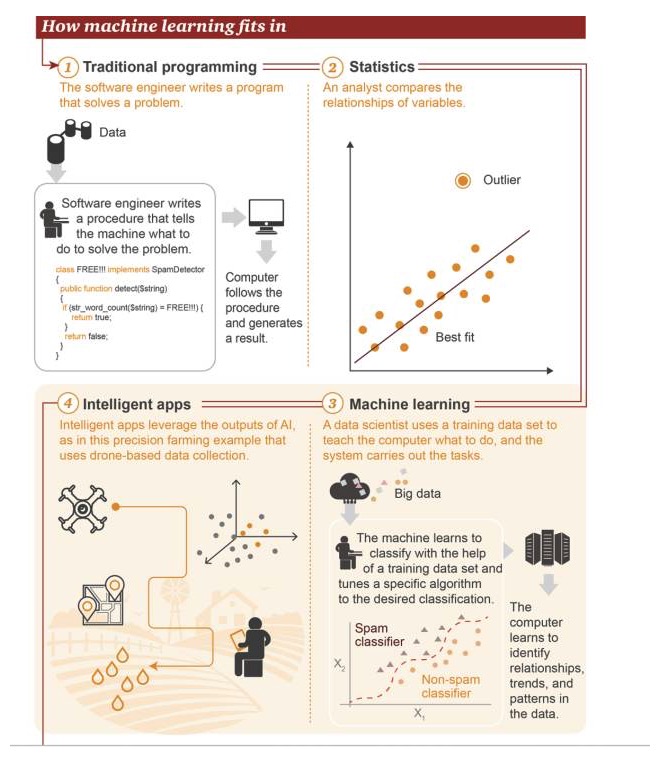

機械学習がどこにいるか

1 伝統的なプログラミング:ソフトウェアエンジニアは問題を解決するためにプログラムを書く.まず,いくつかのデータがある→問題を解決するために,ソフトウェアエンジニアはマシンに何をすべきかを伝えるプロセスを書きます→コンピュータはこのプロセスを実行し,結果を出します. 2 統計学:分析者が変数との関係を比較する 3 マシン学習:データサイエンティストはトレーニングデータセットを使用してコンピュータに何をすべきかを教え,次にシステムがそのタスクを実行します. まず,ビッグデータがあります→機械はトレーニングデータセットを使用して分類することを学び,目標分類を達成するために特定のアルゴリズムを調整します→コンピュータはデータ内の関係,傾向,パターンを認識することを学ぶことができます. 4 スマートアプリケーション: スマートアプリケーションが人工知能を用いた結果を示している図は,ドローンによって収集されたデータに基づいた精密農業の応用例を示している.

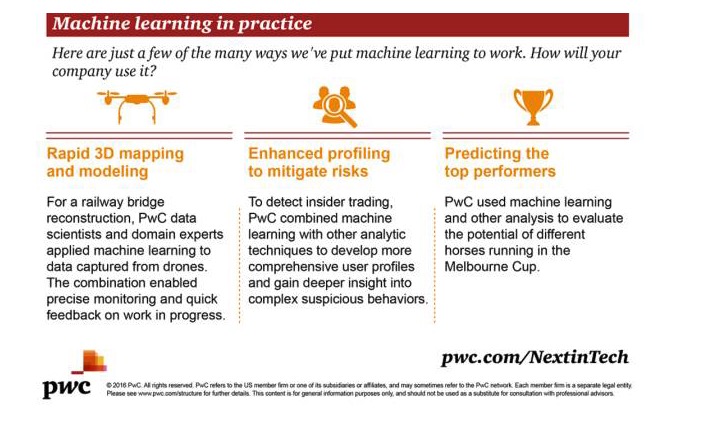

機械学習の実用化

機械学習には多くの応用シナリオがあります. ここでいくつかの例を示します.

急速3Dマッピングとモデリング:鉄道橋を建設するために,PwCのデータ科学者と分野専門家が機械学習を無人機によって収集されたデータに適用した.この組み合わせは,仕事の成功の精密な監視と迅速なフィードバックを実現した.

リスクを低減するための強化分析:PwCは,内部取引を検出するために,機械学習と他の分析技術を組み合わせ,より包括的なユーザープロフィールを開発し,複雑な疑わしい行動についてより深い理解を得ました.

予想するベストパフォーマンス目標:PwCは,機械学習と他の分析方法を使用して,メルボルンカップ競技場における異なる競馬の可能性を評価する.

- #### ###########################################################################################################################################################################################################################################################

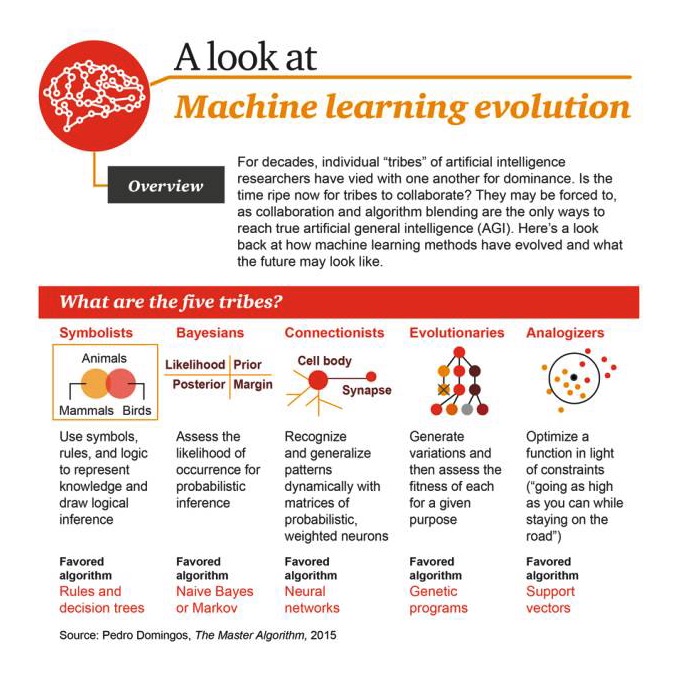

何十年もの間,AI研究者の様々な"部族"は,互いに優位性争い続けてきました. 今こそ,部族が団結する時が来たのでしょうか? 協力とアルゴリズムの融合が真の汎用AI (AGI) を実現する唯一の方法であるため,彼らはそうしなければならないかもしれません. ここで,機械学習方法の進化の道筋と将来の可能性を示しています.

五大流派

1 シンボル主義:知識を表し,論理推論を行うためにシンボル,ルール,論理を使用する.好きなアルゴリズムは:ルールと意思決定ツリー 2 ベイチェス派: 発生の可能性を入手して確率推論を行う. 好きなアルゴリズムは:朴素なベイチェスやマルコフ 3連結主義:確率マトリックスと加重ニューロンを用いて,パターンを動的に認識し,帰納する. 4 進化論: 変化を生成し,その中で最も優れたものを特定目的のために選出する 5 アナログライザー: 制限条件によって関数を最適化する (できるだけ高く行くが,同時に道路から離れない) 好きなアルゴリズムは: ベクトルマシンをサポートする

進化の段階

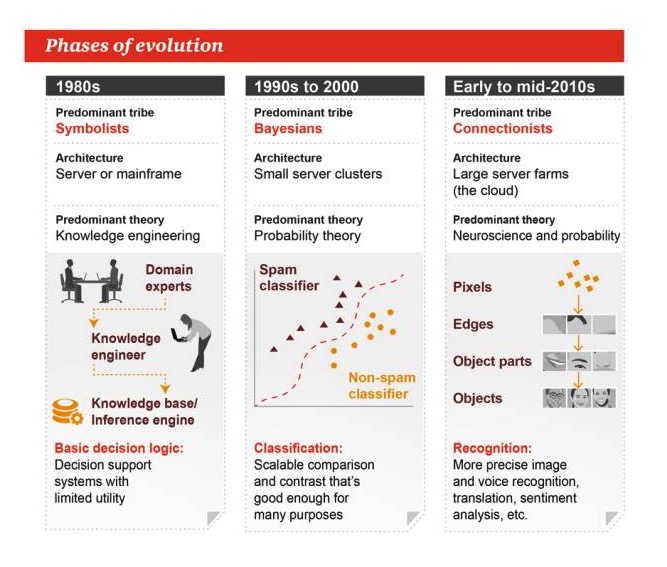

1980年代

主流ジャンル:シンボリズム アーキテクチャ:サーバーまたは大型マシン 主要理論:知識工学 基本的な意思決定論理:意思決定支援システム,実用性は限られている

1990年代から2000年

主流ジャンル:ベイズ アーキテクチャ:小型サーバークラスター 主な理論:確率論 分類:拡張可能な比較や対比は,多くのタスクに十分です

2010年代初頭から中期

主流ジャンル:連結主義 アーキテクチャ:大型サーバーファーム 主な理論:神経科学と確率 認識:より正確な画像と音声認識,翻訳,感情分析など

芸術の分野は,芸術の分野と,芸術の分野は,芸術の分野と,芸術の分野と,

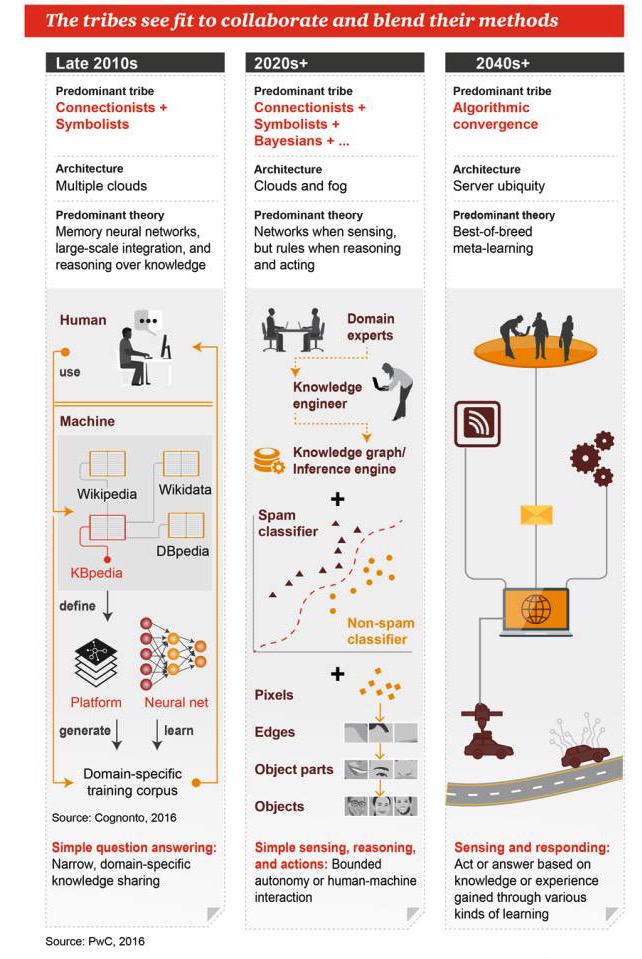

2010年代後半

主流ジャンル:連結主義+シンボリズム 建築:多くの雲 主な理論:記憶神経ネットワーク,大規模統合,知識に基づく推論 簡単な質問と答え: 狭い範囲で,分野特有の知識を共有する

2020年代+

主流ジャンル:連結主義+シンボル主義+ベイエス+...... 建築:クラウドコンピューティングと霧コンピューティング 主要な理論:知覚するときにネットワークがあり,推論するときにルールがあります. シンプルな認識,推論,行動:制限された自動化や人体相互作用

2040年代+

主流ジャンル: アルゴリズム融合 建築: どこにでもいるサーバー 主な理論:ベストな組み合わせのメタ学習 認識と反応:様々な学習方法によって得られた知識や経験に基づいて行動または応答する

- #### ###########################################################################################################################################################################################################################################################

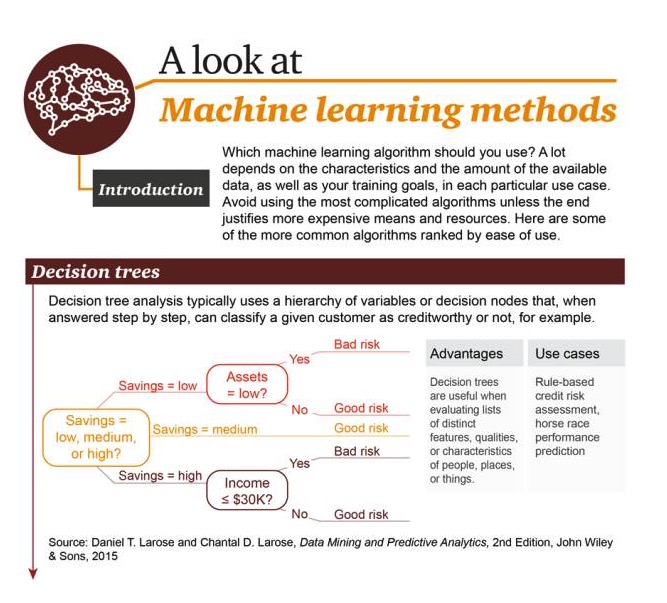

どの機械学習アルゴリズムを使うべきか?これは,利用可能なデータの性質と量,およびそれぞれの特定の用例におけるあなたのトレーニング目標に大きく依存します. 結果が高価な費用とリソースに価値がある場合を除き,最も複雑なアルゴリズムを使用しないでください. ここで最も一般的なアルゴリズムをいくつか挙げています.

決定樹 (Decision Tree): 段階的な応答の過程で,典型的な決定樹分析は,階層化変数または意思決定ノードを使用して,例えば,特定のユーザを信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用信用.

優位性: 人,場所,物事の様々な特徴,性質,特性を評価する能力 ケース例:ルールに基づく信用評価,競馬結果予測

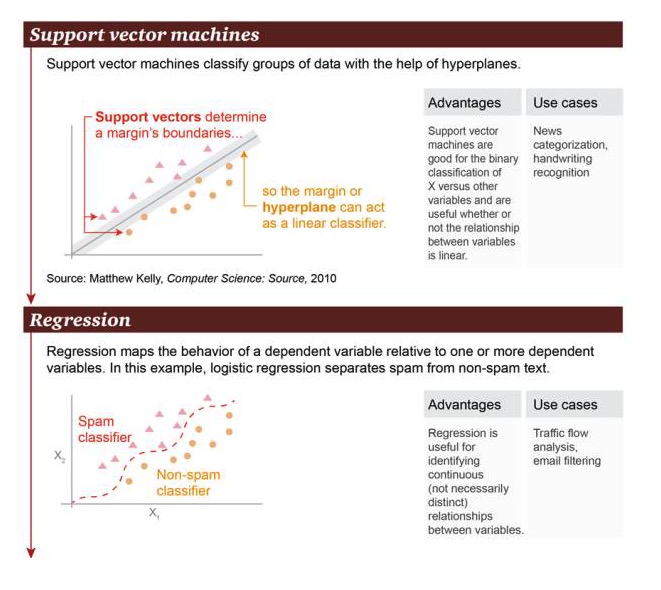

サポートベクトルマシン:ハイパープレーンに基づいたベクトルマシンがデータセットを分類することをサポートする.

利点: ベクトルマシンのサポート,関係が線形であるかどうかにかかわらず,変数 X と他の変数との間の二次分類操作を熟知する ニュース分類,手書き識別など.

リグレーション (Regression):リグレーションは,因数と"つまたは複数の因数間の状態関係を描画する.この例では,スパムと非スパムが区別される.

利点は:回帰は,関係が非常に顕著でない場合でも,変数間の連続関係を識別するために使用できます. 局面例:道路交通流量分析,メールフィルタリング

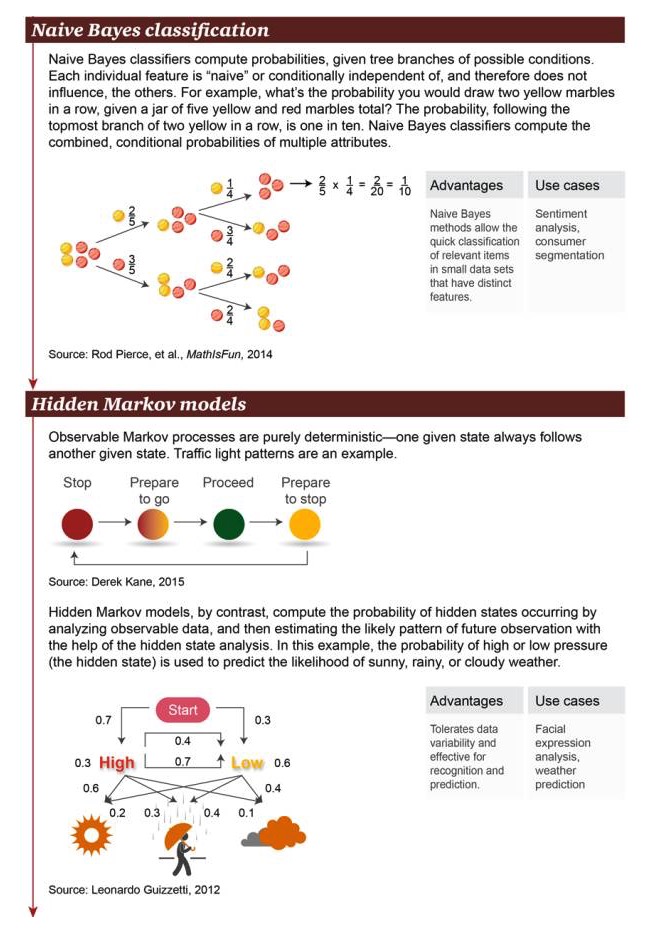

ナイヴ・ベイヤー分類:ナイヴ・ベイヤー分類は,可能な条件の分岐確率を計算するために用いられる.各個別特質は"素朴"または条件独立であるため,他のオブジェクトに影響しない.例えば,5つの黄色と赤の球が揃ったオートブレイクで,連続して2つの黄色い球が取られる確率は?図の上部から見えるように,前後に2つの黄色い球を掴む確率は1/10である.ナイヴ・ベイヤー分類は,複数の特性を組み合わせた条件の確率を計算することができる.

利点: 小規模なデータセットで顕著な特徴を持つ関連オブジェクトに対して,朴素なベイエス方法により迅速な分類が可能である 情景例:感情分析,消費者の分類

隠されたマルコフモデル: 明らかにマルコフプロセスは完全に確実である.ある状態がしばしば別の状態を伴います. 交通信号は例です. 相反に,隠れたマルコフモデルは,可視データを分析することによって隠れた状態の発生を計算します. その後,隠れた状態分析を使用して,隠れたマルコフモデルは,将来の観測パターンの可能性を推定します. この場合,高気圧または低気圧の確率 (隠れた状態) は,晴れの日,雨の日,曇りの日の確率を予測するために使用されます.

利点:データの変容性を許し,認識と予測操作に適している 顔面分析,天気予報など

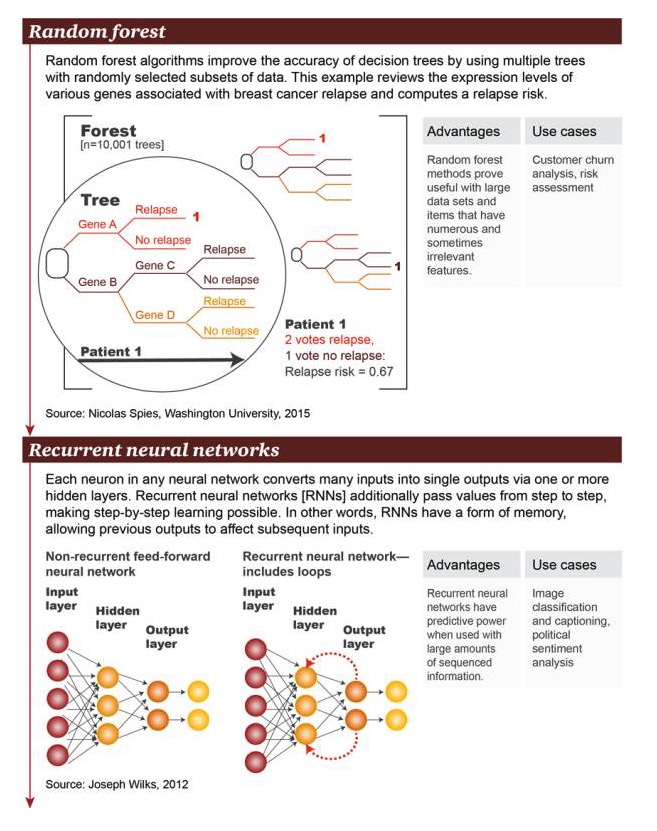

ランダムフォレスト:ランダムフォレストアルゴリズムは,ランダムに選択されたデータサブセットを持つ複数のツリーを使用して意思決定ツリーの精度を改善した.この例では,遺伝子発現レベルで乳がん再発に関連した多くの遺伝子を調べ,再発リスクを計算した.

利点:ランダムフォレスト方法は,大規模なデータセットと大量の,時には関連のない特徴がある項目の (item) ために有用であることが証明されています. ケース例:ユーザー損失分析,リスク評価

循環神経ネットワーク (Recurrent neural network):任意の神経ネットワークでは,各ニューロンが1つまたは複数の隠された層を通過して多くのインプットを単一の出力に変換する.循環神経ネットワーク (RNN) は,値をさらに層次的に伝達し,層次的な学習を可能にします.つまり,RNNは,以前の出力が後の出力を影響することを許す某種の記憶が存在します.

利点: 循環神経ネットワークは,大量に秩序ある情報が存在する場合に予測する能力を持っています. 画像の分類と字幕の追加,政治感情分析

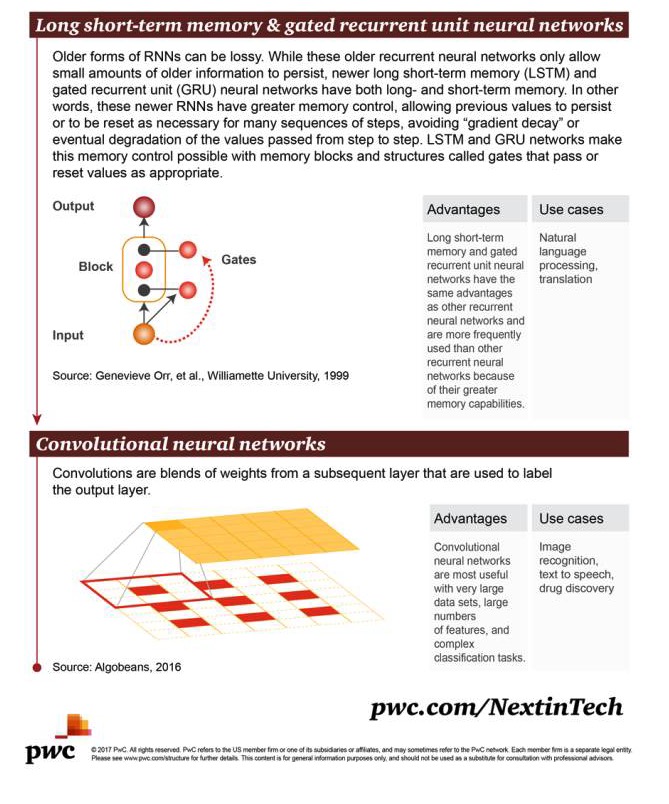

長短期記憶 (LSTM) とゲートリキュレンントユニットネルーアルネットワーク (gated recurrent unit neural network):初期の形式のRNNには損失がある.しかし,これらの初期の循環型ニューラルネットワークは初期情報のわずかな部分しか保持することができないが,新しいLSTMとゲートリキュレンントユニット (GRU) のニューラルネットワークは,長期と短期間の記憶の両方を備えている.つまり,これらの新しいRNNは,以前の処理を保持したり,多くの一連のステップが必要であるときにそれらの値を再設定することを可能にするより良い制御記憶能力を有し,これは"梯次衰退"や階層的な値の最終的な劣化を回避する.LSTMとGRUネットワークは",ゲート"と呼ばれるメモリモジュールまたは構造の制御メモリを使用することを可能にします.この構造は,値の転送時に適応または再設定することができます.

利点:長期短期記憶とゲート制御循環細胞神経ネットワークは,他の循環神経ネットワークと同じ利点があるが,より優れた記憶能力があるため,より頻繁に使用されている. 自然言語処理,翻訳

卷曲神経ネットワーク (convolutional neural network):卷曲とは,次層からの重量の融合を意味する.出力層をマークするために使用される.

利点:非常に大きなデータセット,多くの特徴,複雑な分類作業がある場合,カプセルニューラルネットワークは非常に便利です シーンの例:画像認識,テキスト変換,薬物発見

- #### オリジナルリンク:

http://usblogs.pwc.com/emerging-technology/a-look-at-machine-learning-infographic/

http://usblogs.pwc.com/emerging-technology/machine-learning-methods-infographic/

http://usblogs.pwc.com/emerging-technology/machine-learning-evolution-infographic/

ビッグデータ・プレイスから

- なぜ方差が分散度を表すのか?

- 程序化された取引モデルの失敗を判断する方法

- BitMEX exchange API note BitMEX取引所APIの利用条件

- トレンド取引の極端な取引が明らかになった

- コードで正確に調整する

回響システム デフォルト設定 - 高周波戦略

- 選択肢の使い方について

- ビットコインのハイ周波収穫機1号戦略が実現する

- 未来市場におけるあらゆる利害関係者を理解する

- 多頭運動は逆転する戦略

- 利潤を決定する分水槽の一致性

- 2.14 取引所のAPIを呼び出す方法

- 最近のEthやEthプラットフォームの各種類のコインビルについてどう思いますか?

- ゼロ

- 夜間期貨を保管するための6つのコツ

- 期貨のオートナイト取引 (トレンド取引) の金石の良い言葉

- 遊び心

- 散歩の謎

- シャープ比率は0.6で,捨てられるか?

- 投票決定は,時間と均等な投票戦略ではなく,